Les méthodes statistiques permettent parfois de traiter des problèmes surprenants. Il peut nous arriver à tous d’être mis en présence de personnes se qualifiant de « voyants » ou de « médiums » et donc dotées de pouvoirs surnaturels. Il est très difficile de réagir face à ce genre de prétention. Un scepticisme systématique permet aux tenants de la voyance de vous qualifier d’esprit fermé, et donc non scientifique. L’acceptation du surnaturel (un concept étrange, tous les phénomènes réels étant par essence naturels) vous fera très vite passer pour naïf.

a priori de toute prétention. Des méthodes statistiques permettent de tester efficacement les performances réalisées effectivement par les tenants de l’existence de ce genre de phénomènes. Ce qui est intéressant, c’est que cette étude statistique permet aussi de redécouvrir tous les aspects de la théorie des tests d’hypothèses !

a priori de toute prétention. Des méthodes statistiques permettent de tester efficacement les performances réalisées effectivement par les tenants de l’existence de ce genre de phénomènes. Ce qui est intéressant, c’est que cette étude statistique permet aussi de redécouvrir tous les aspects de la théorie des tests d’hypothèses !

Les vertus du scepticisme

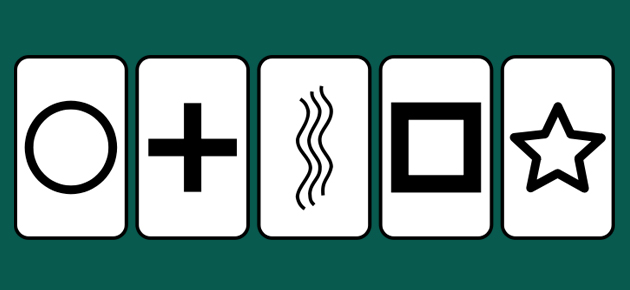

C’est l’Américain Banks Rhine qui fut l’un des premiers à étudier les phénomènes paranormaux de manière scientifique. Dans ce but, il créa en 1920 un jeu de vingt-cinq cartes représentant cinq symboles facilement dissociables, repris chacun cinq fois sous cinq couleurs différentes (noir, bleu, rouge, jaune et vert). Connu aujourd’hui sous l’appellation ESP (pour extra sensory perception, « perception extrasensorielle »), ce jeu fut baptisé « cartes de Zener » par Banks Rhine, en hommage à l’un de ses collègues, Karl Edward Zener (1903–1964). Il comprend cinq cartes croix, cinq cartes vague, cinq cartes rond, cinq cartes carré et cinq cartes étoile.

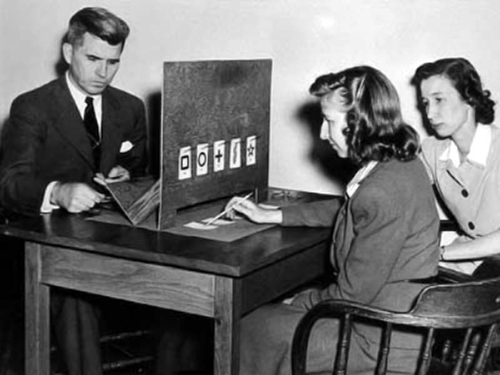

Les tests visant au contrôle des dons de voyance s’intègrent parfaitement dans la statistique inférentielle. Tout commence par un protocole expérimental. À partir du jeu de cartes de Zener, des expériences élémentaires sont réalisées : on propose à un candidat émetteur de se concentrer sur l’un des cinq symboles et l’on demande au « voyant » de désigner l’un des cinq symboles. Lorsque le symbole envoyé mentalement par le volontaire coïncide avec celui désigné par le voyant, on considère que l’expérience a réussi. Lorsque ce n’est pas le cas, on dit que l’expérience à échoué. Les mathématiciens auront identifié ici un schéma de Bernoulli, débouchant sur une distribution binomiale.

Les tests visant au contrôle des dons de voyance s’intègrent parfaitement dans la statistique inférentielle. Tout commence par un protocole expérimental. À partir du jeu de cartes de Zener, des expériences élémentaires sont réalisées : on propose à un candidat émetteur de se concentrer sur l’un des cinq symboles et l’on demande au « voyant » de désigner l’un des cinq symboles. Lorsque le symbole envoyé mentalement par le volontaire coïncide avec celui désigné par le voyant, on considère que l’expérience a réussi. Lorsque ce n’est pas le cas, on dit que l’expérience à échoué. Les mathématiciens auront identifié ici un schéma de Bernoulli, débouchant sur une distribution binomiale.

Il convient évidemment de veiller à ce qu’aucune communication entre le voyant et l’émetteur ne puisse intervenir, ce qui demande toute une procédure de contrôle… C’est d’ailleurs à ce niveau que les plus grandes critiques furent adressées à Rhine : le protocole mis en place par son équipe ne pouvait écarter les risques de fraudes.

La procédure expérimentale permet de compter le nombre r de réussites et le nombre e d’échecs obtenus après n expériences (avec r + e = n). On calcule la fréquence f observée de réussites, à savoir r / n. Faisons l’hypothèse que quarante expériences ont été réalisées et que le « voyant » s’est vu attribuer douze réussites, ce qui donne une fréquence observée f égale à 12 / 40, soit 0,3. Ce résultat est-il significatif ?

Pour le savoir, il convient de placer l’expérience dans le contexte théorique du calcul des probabilités. Dans ce cadre, tout scientifique se doit de développer une attitude sceptique. Le modèle théorique mis en place doit donc être basé sur l’hypothèse de la non-existence des phénomènes paranormaux. Cette hypothèse se traduit par une « probabilisation » rendant compte de cette hypothèse : à l’évènement « Réussite » on associe une probabilité (fréquence théorique établie en dehors du contexte expérimental) égale à p = 1/5, les cinq symboles étant considérés équiprobables. L’expérimentateur considère que le « voyant » n’a aucune raison objective de choisir l’un des cinq symboles plutôt qu’un autre et que seul le hasard joue. L’évènement « Échec » se voit attribuer la probabilité complémentaire q = 1 – p = 4 / 5.

Il convient à présent de comparer les points de vue expérimentaux et théoriques pour répondre à la question : la différence entre f et p révèle-t-elle une anomalie, ou bien ces deux valeurs numériques sont-elles « proches » (un concept à définir), la différence observée n’étant due qu’au hasard, c’est-à-dire à un ensemble d’éléments non contrôlables ?

Les maths sont dans la place

Abraham De Moivre (1667–1754).

La réponse à notre question est apportée par la statistique inférentielle et ses lois des grands nombres. Le théorème de Moivre–Laplace permet d’approcher la distribution binomiale par une distribution normale. Comment cela fonctionne-t-il ?

Dès 1730, partant de la formule de Stirling donnant une approximation exponentielle de la factorielle, le mathématicien français Abraham De Moivre approche la loi de probabilité de la distribution binomiale par ce qui deviendra la loi dite normale. Il en donnera une présentation complète huit ans plus tard, donnant naissance au premier embryon du célèbre théorème central limite. Le théorème de Moivre–Laplace établit que la fonction de répartition d’une distribution binomiale réduite (variable moins sa moyenne, le tout divisé par l’écart type) converge (au sens de la convergence simple des fonctions) vers la fonction de répartition d’une variable normale de moyenne 0 et d’écart type 1 lorsque le nombre d’expériences identiques et indépendantes tend vers l’infini. Il n’établit pas la convergence des variables proprement dites mais permet en pratique tous les calculs de probabilité avec une précision suffisante.

Dans notre cas, pour une fréquence théorique p et la réalisation de n expériences, la fréquence observée f vérifiera les inégalités suivantes avec une probabilité de 95 % :

On y reconnaît la valeur moyenne p de la loi binomiale au centre de l’intervalle, et aussi l’écart type de la distribution comme facteur du coefficient 1,96 bien connu des statisticiens et qui est associé au niveau de probabilité choisi ici (95 %). Dans le cas de l’exemple, on obtient :

La valeur observée, f = 0,3, appartient bien à l’intervalle des valeurs attendues. En utilisant le vocabulaire statistique, on dit qu’il n’y a pas de différence significative entre le résultat théorique p et le résultat observé f . Notre « voyant » n’est pas exceptionnel : réaliser 30 % de résultats positifs en quarante expériences de probabilité de réussite 20 % n’a rien d’inattendu. Il demeure étrange cependant que les résultats obtenus par Rhine se retrouvaient quant à eux pour la plupart hors intervalle… Naïveté du protocole ? Manipulation ? Présence d’un vrai « voyant » ? Nous vous laissons le soin de vous forger une opinion…