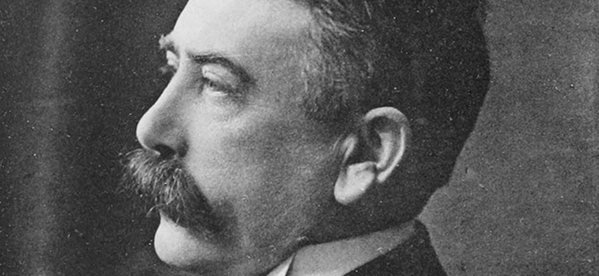

Pendant longtemps, on a considéré que les langues anciennes avaient atteint la perfection et que les langues vernaculaires n'en étaient que de pâles descendants. Surtout, jusqu'à la fin du xixe siècle, primait l'étude diachronique des langues, c'est-à-dire qu'on étudiait avant tout leur évolution. Ferdinand de Saussure a bouleversé cette approche en considérant qu'une langue est un système muni d'une structure dont les différents composants s'articulent entre eux pour donner du sens. Ainsi, une étude scientifique devenait possible et les mathématiques pouvaient en servir de support.

Cette approche s'appelle syntaxique, du fait qu'elle étudie le fonctionnement de la phrase, comme la place du sujet, du verbe, du complément en faisant abstraction du sens ; celui-ci s'étudie pour sa part dans le cadre de la sémantique.

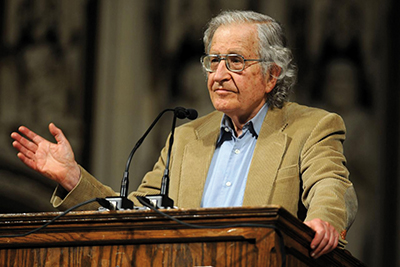

Un schéma commun

Le linguiste américain Noam Chomsky affirme que nous possédons, de façon innée, une structure du langage qu'il suffit d'activer pour assimiler notre langue maternelle. Il existe ainsi, selon lui, un schéma commun à toutes les langues, déconnecté du sens : c'est ce qu'il appelle la grammaire générative. Sa démarche considère donc la syntaxe comme indépendante de la sémantique. Bien qu'il n'y fasse pas référence, il reprend totalement la méthode de la logique formelle introduite un demi-siècle avant lui par le logicien Gottlob Frege ; celle-ci décrit et étudie des schémas logiques indépendamment du sens.

Pourtant, un quart de siècle avant Chomsky, le mathématicien Alfred Tarski et le linguiste danois Louis Hjelmslev, lui-même fils d'un mathématicien, avaient affirmé que la langue ne pouvait être incluse dans un schéma purement logique. Les subtilités, les non-dits, les caractères allusifs ne se réduisent pas à un schéma logique. Plus grave, des phrases comme « la phrase que j'énonce est fausse » est correcte au niveau de la syntaxe, mais à rejeter au niveau de la logique, puisqu'on ne peut lui donner ni la valeur vraie, ni la valeur fausse !

La fréquence d'apparition des mots dans un texte, ou des phonèmes dans une langue est une interrogation qui date ; l'outil informatique en permet une utilisation plus systématique. C'est pourtant bien avant, en calculant le nombre d'occurrences de chaque mot dans l'énorme livre Ulysse de James Joyce, que George Zipf a affirmé que le nombre d'apparitions dans un texte du nième mot le plus fréquent est approximativement K / n (où K désigne une constante). Il estimait que c'était le cas dans pratiquement toutes les langues et pour une grande variété de textes. Cette loi n'est qu'approximative et, mathématiquement, asymptotiquement impossible puisque la série harmonique… diverge. Cependant, non seulement elle donne une approximation acceptable, mais elle se retrouve appliquée dans d'autres domaines comme, par exemple, la population des villes d'un pays ou la longueur des fleuves (voir Mathématiques et Géographie, Bibliothèque Tangente 40, 2010). Depuis, de nombreuses études statistiques sur la fréquence des mots d'un texte ou d'un discours ont été utilisées pour analyser les différences de niveau de langages des auteurs. Elles utilisent cependant des statistiques élémentaires et très empiriques.

L'outil de la communication

La langue est clairement l'outil premier de la communication. La parution en 1949 de l'ouvrage The Mathematical Theory of Communication (University of Illinois Press), dans lequel Claude Shannon et Warren Weaver ont posé les bases d'une théorie scientifique de l'information, a permis un autre regard sur la linguistique. En particulier, on s'interroge sur la quantité d'information qu'apporte l'énoncé d'un son, d'un mot, d'une phrase. Pour le quantifier, il est nécessaire de définir les éléments minimaux de la parole, comme ceux du langage : à savoir le niveau phonétique pour le premier, sémantique pour le second.

On définit ainsi le phonème, unité minimale de la parole, à ne pas confondre avec un son ; ainsi, que l'on prononce le r roulé comme certains dans le Sud de la France ou grasseyé, il s'agit du même phonème. De même, le morphème est l'unité minimale du point de vue du sens. Ainsi, « mang/er/ons » possède trois morphèmes, puisque ce mot indique l'action de manger, le futur et la première personne du pluriel, alors que « pomme de terre » ne possède qu'un seul morphème : on ne peut le diviser en sous-unités au niveau du sens (en aucun cas les mots « pomme » et « terre » ne sont des éléments sémantiques de « pomme de terre »).

Dans le cadre de la théorie de l'information, on cherche à déterminer la diversité de la langue, c'est-à-dire à mesurer la quantité d'information qu'elle véhicule. Si l'on se place au niveau phonologique, il s'agit par exemple de considérer le nombre de phonèmes de la langue. On définit alors l'entropie de Shannon H par l'opposé de la somme, sur tous les phonèmes, des pk log2(pk), où pk est la probabilité d'apparition du phonème k (voir notre article). Plus cette quantité est grande, plus la langue est diverse.

Plus récemment, la mondialisation a engendré un besoin croissant de traduction. Les premières approches se sont intéressées à la syntaxe et à la sémantique. Cependant, la première varie énormément d'une langue à l'autre, tandis que les sens figurés et les expressions idiomatiques rendent insuffisante les correspondances mot à mot. Des approches nouvelles, principalement élaborées par des opérateurs du domaine du Web, on préféré des méthodes purement statistiques ; elles se sont révélées beaucoup plus efficaces (voir en encadré).

Une fois encore, des interrogations a priori purement théoriques sur la langue se montrent, par la suite, d'une grande utilité pratique et les mathématiques se révèlent être un support d'étude indispensable.